Quarta-feira, 21 de janeiro de 2026

Quarta-feira, 21 de janeiro de 2026

Por Redação do Jornal O Sul | 20 de janeiro de 2026

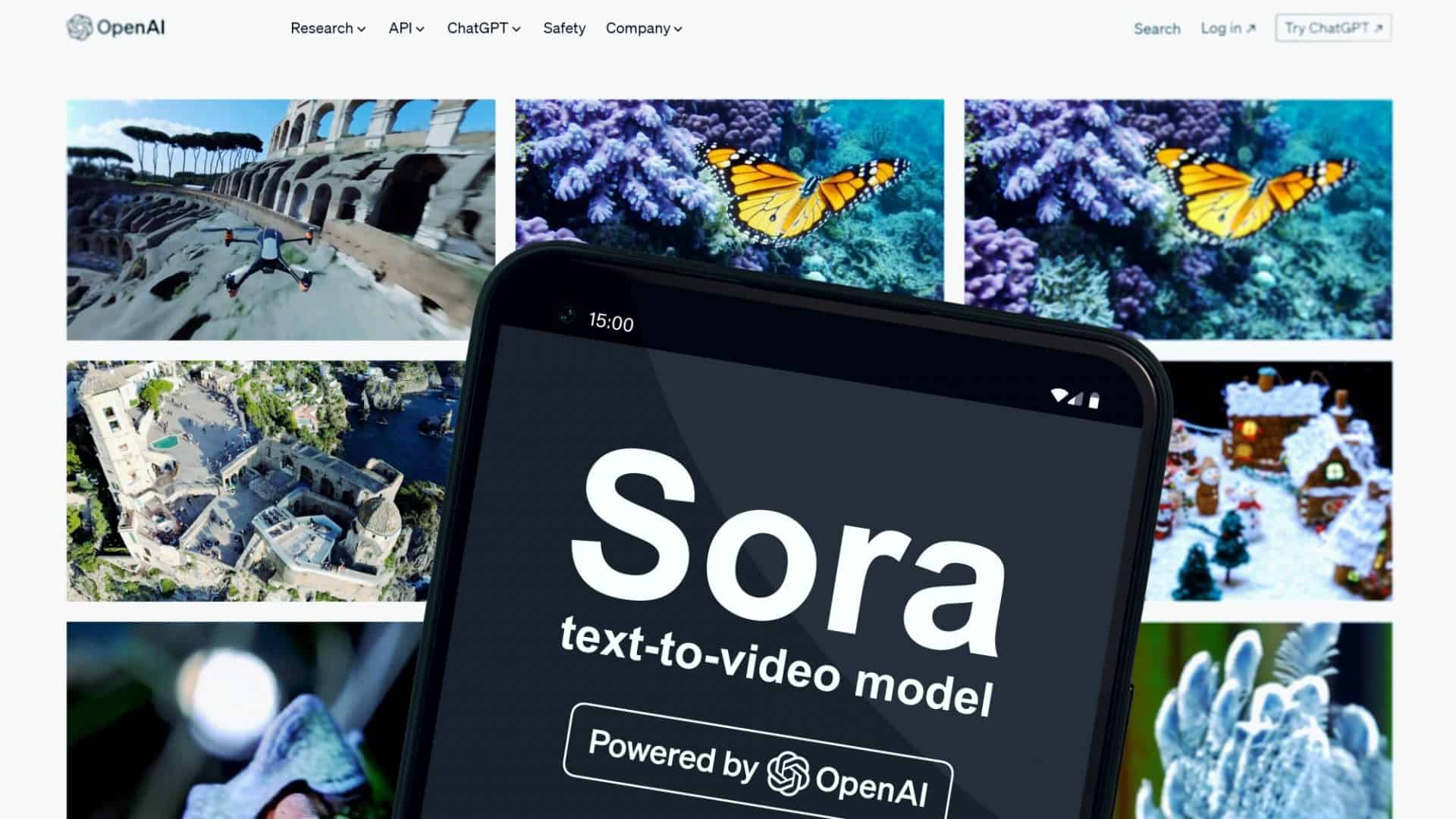

A OpenAI, criadora do popular chatbot ChatGPT, é dona de um aplicativo com uma tecnologia para a qual a maioria de nós provavelmente não estava preparada. Chamado Sora, ele permite aos usuários gerar instantaneamente vídeos de aparência realista com inteligência artificial, bastando digitar uma descrição simples, como: “filmagem de câmera corporal da polícia mostrando um cachorro sendo preso por roubar um bife de costela no Costco”.

O Sora, um aplicativo gratuito para iPhones, tem sido tão divertido quanto perturbador. Desde seu lançamento, muitos dos primeiros usuários publicaram vídeos apenas por diversão, como filmagens falsas de um guaxinim em um avião ou brigas entre celebridades de Hollywood no estilo de anime japonês. Eu, por exemplo, me diverti criando vídeos falsos de um gato flutuando para o céu e de um cachorro escalando pedras em uma parede de escalada em uma academia.

Mas outros têm usado a ferramenta para fins mais nefastos, como disseminar desinformação — incluindo falsas gravações de segurança de crimes que nunca aconteceram. Quando estreou em outubro junto com uma plataforma social semelhante ao TikTok, os usuários geraram e postaram clipes de Bob Esponja cozinhando metanfetamina, deepfakes de Martin Luther King Jr. e John F. Kennedy dizendo coisas que nunca pronunciaram, e um comercial falso de um modelo de brinquedo da ilha privada do falecido criminoso sexual Jeffrey Epstein.

Quebra de paradigma

O surgimento do Sora, junto com geradores de vídeo movidos por IA lançados pela Meta e pelo Google, tem grandes implicações. Essa tecnologia pode representar o fim do “fato visual” — a ideia de que o vídeo pode servir como um registro objetivo da realidade — tal como a conhecemos. A sociedade, como um todo, terá de passar a tratar vídeos com o mesmo ceticismo com que já trata as palavras.

No passado, os consumidores tinham mais confiança de que as fotos eram reais (“Sem fotos, não aconteceu!”), e quando as imagens se tornaram fáceis de falsificar, o vídeo — que exigia muito mais habilidade para ser manipulado — passou a ser o padrão para comprovar a veracidade de algo. Agora, isso também acabou.

Nossos cérebros são fortemente programados para acreditar no que vemos, mas podemos — e devemos — aprender a pausar e refletir agora sobre se um vídeo, ou qualquer mídia, realmente mostra algo que aconteceu no mundo real — disse Ren Ng, professor de ciência da computação na Universidade da Califórnia, em Berkeley, que ministra cursos sobre fotografia computacional.

O Sora marca um ponto de virada na era das falsificações por inteligência artificial. Os consumidores podem esperar que imitadores surjam nos próximos meses, inclusive de agentes mal-intencionados oferecendo geradores de vídeo com IA sem qualquer tipo de restrição.

“Ninguém vai mais estar disposto a aceitar vídeos como prova de nada”, disse Lucas Hansen, fundador da CivAI, uma organização sem fins lucrativos que educa o público sobre as capacidades da inteligência artificial.

Um porta-voz da OpenAI afirmou que a empresa lançou o Sora como um aplicativo próprio para oferecer às pessoas um espaço dedicado a apreciar vídeos gerados por IA e reconhecer que eles foram feitos com IA. A empresa também integrou tecnologias que tornam os vídeos fáceis de rastrear até o Sora, incluindo marcas d’água e dados embutidos nos arquivos de vídeo que funcionam como assinaturas digitais, segundo ele.

“Nossas políticas de uso proíbem enganar outras pessoas por meio de personificação, golpes ou fraudes, e tomamos medidas sempre que detectamos mau uso”, afirmou a empresa.

Fique atento

Embora os vídeos gerados com o Sora incluam uma marca d’água com o logotipo do aplicativo, alguns usuários já perceberam que podem cortar essa marca fora. Os clipes feitos com o Sora também tendem a ser curtos — com duração de até 10 segundos.

Qualquer vídeo que apresente uma qualidade semelhante à de uma produção de Hollywood pode ser falso, pois, segundo Lucas Hansen, os modelos de IA foram em grande parte treinados com imagens de séries e filmes disponíveis na internet. Todavia, às vezes apresentam erros evidentes, como erros de grafia em nomes de restaurantes e fala dessincronizada com o movimento da boca das pessoas.

No entanto, qualquer dica sobre como identificar um vídeo gerado por IA tende a ficar obsoleta rapidamente, porque a tecnologia está evoluindo muito depressa, afirmou Hany Farid, professor de ciência da computação na Universidade da Califórnia, em Berkeley, e fundador da GetReal Security, uma empresa que verifica a autenticidade de conteúdo digital.

“As redes sociais são um verdadeiro lixão”, disse Farid, acrescentando que uma das maneiras mais seguras de evitar vídeos falsos é parar de usar aplicativos como TikTok, Instagram e Snapchat.